Les 10 fondamentaux de l’Inbound Marketing

16 Avr 2015, Posté par dans A la une, DigitalLes racines de l’inbound marketing

L’inbound marketing tel qu’inventé et définis au début des années 2000 par Brian Halligan (Hubspot) et popularisé par le conférencier, écrivain et gourou Seth Godin (www.sethgodin.com/sg/) est une discipline nouvelle dont fait partie le marketing digital. Il peut de traduire par « marketing entrant » et consiste à faire venir les futurs clients vers soi plutôt que d’aller les chercher (outbound marketing, inventé récemment par opposition). L’outbound, est en fait assimilé à la « com’ de papa », le type de communication et de marketing défini au début du siècle dernier avec la « réclame », sur affiches d’abord, tracts, crieurs de rue, et dont la tradition remonte sans doute aux marchés de l’antiquité. Les journaux, puis revues et magazines, la radio, le cinéma, et enfin la télévision, sans oublier internet, ont tous servi de support à des types à peine améliorés de « réclame » dans lequel on met en valeur directement le produit, ses qualités, les avantages qu’il procure et parfois son tarif avantageux…

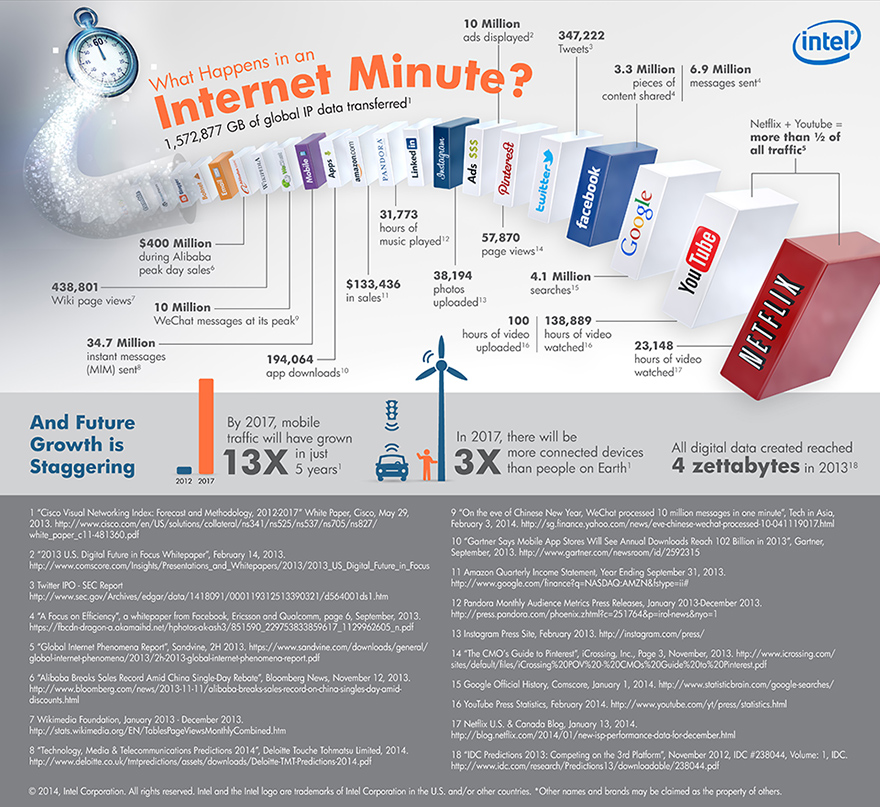

Depuis l’émergence des réseaux sociaux et des communautés, l’ère du digital à fait basculer ce concept, qui ne crée presque plus de conversions avec le public sur-informé et méfiant du début du XXIe siècle. On se dirige en effet vers une toute nouvelle forme d’engagement, basée sur la création d’une identité forte et originale, accompagnée de ‘Story Telling’, révolutionnant la manière de faire du marketing et de la communication. On provoque un intérêt graduel du public par le développement d’une présence et d’un univers, qui va, lentement mais surement, faire prendre au client conscience de la marque ou du produit (« brand awareness ») et le « convertir » un peu comme le ferait une secte, faute de trouver meilleure comparaison.

Application

C’est l’utilisation de l’instinct grégaire à des fins commerciales. Il faut donner notamment l’impression au futur client d’appartenir à une « tribu » telle que définie par Seth Godin. L’un des champions naturels de Brand awareness est Macintosh, qui sous l’égide de feu Steve Jobs, a créé un univers bien à part et riche des mêmes attributs qui font la force de l’inbound. D’une certaine manière Gorges Lucas avec sa série Star Wars était aussi un pionnier de l’inbound, avec vingt ans d’avance… Actuellement, Cocal Cola a aussi adopté l’Inbound Marketing comme stratégie principale et multiplie les campagnes avec succès, souvent montrées en exemple.

La pierre angulaire de cette stratégie c’est le contenu: Content is King. Non seulement le contenu lui-même qui participe à cette prise d’attention du prospect, qui se doit d’être aussi varié que possible dans les médias utilisés, mais aussi relayé de la manière la plus fine et la plus intelligente. Ce qui se traduit par des notions de stratégie de contenu (Content Strategy) et le référencement avec les réseaux sociaux (SMO our Social Media Optimisation).

L’inbound marketing est plus large que la stratégie de contenu ou le SMO, il englobe aussi tout le processus aboutissant à la vente, du premier contact jusqu’à l’achat. Il inclus aussi les stratégies d’email marketing, et du suivi analytique en lien avec le SMO pour planifier plus finement ses prochaines campagnes.

Méthodologie de l’inbound marketing

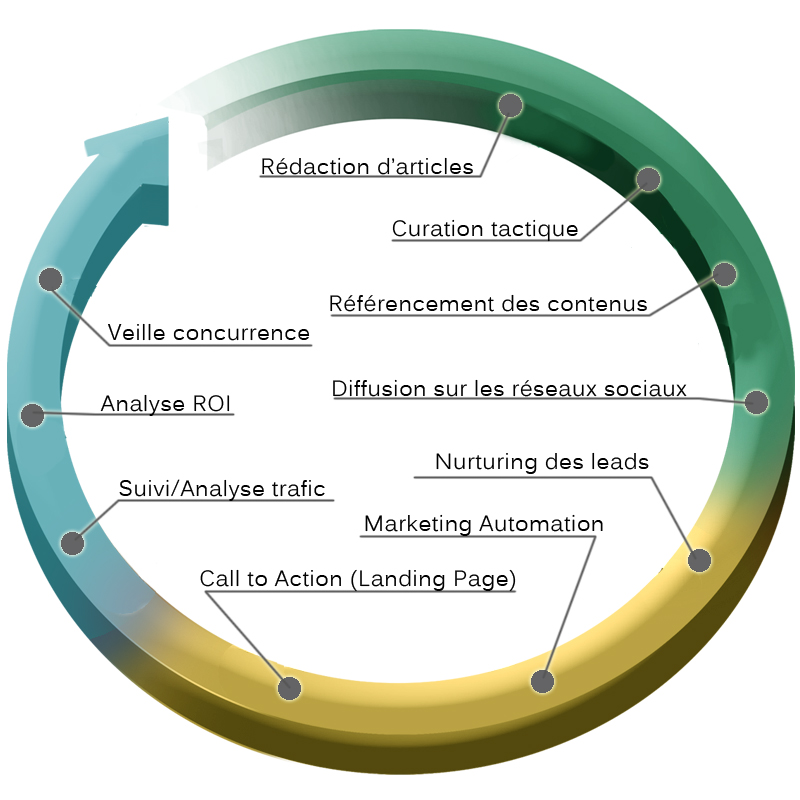

Sa méthodologie peut se synthétiser en trois étapes: Se faire trouver par ses visiteurs (visibilité), convertir ses prospects en clients (conversion), et enfin analyser le processus pour améliorer son offre sur le long terme (Analyse)…

- Rédaction d’articles de qualité sur votre Blog (storytelling et content baiting)

- Curation optimisée (qui peut se faire via un outil de veille) pour accompagner cette prise de volume, avec développement d’authorship

- Optimisation des contenus pour les moteurs de Recherche (SEO)

- Utilisation de réseaux Sociaux divers, complémentaires et/ou adaptés : Facebook, LinkedIn, Twitter, Pinterest, Youtube, DailyMotion, SlideShare…

- Interactivité (Call-to-Action): Bouton inscription sur des landing pages spécifiques (pas forcément la homepage)…

- Nurturing : Les contacts ou prospects (leads) sont mis en terreau afin qu’ils se développent et prospèrent selon un rythme défini

- Automatisation et le pilotage d’actions interactives (ou marketing automation), en utilisant des logiciels.

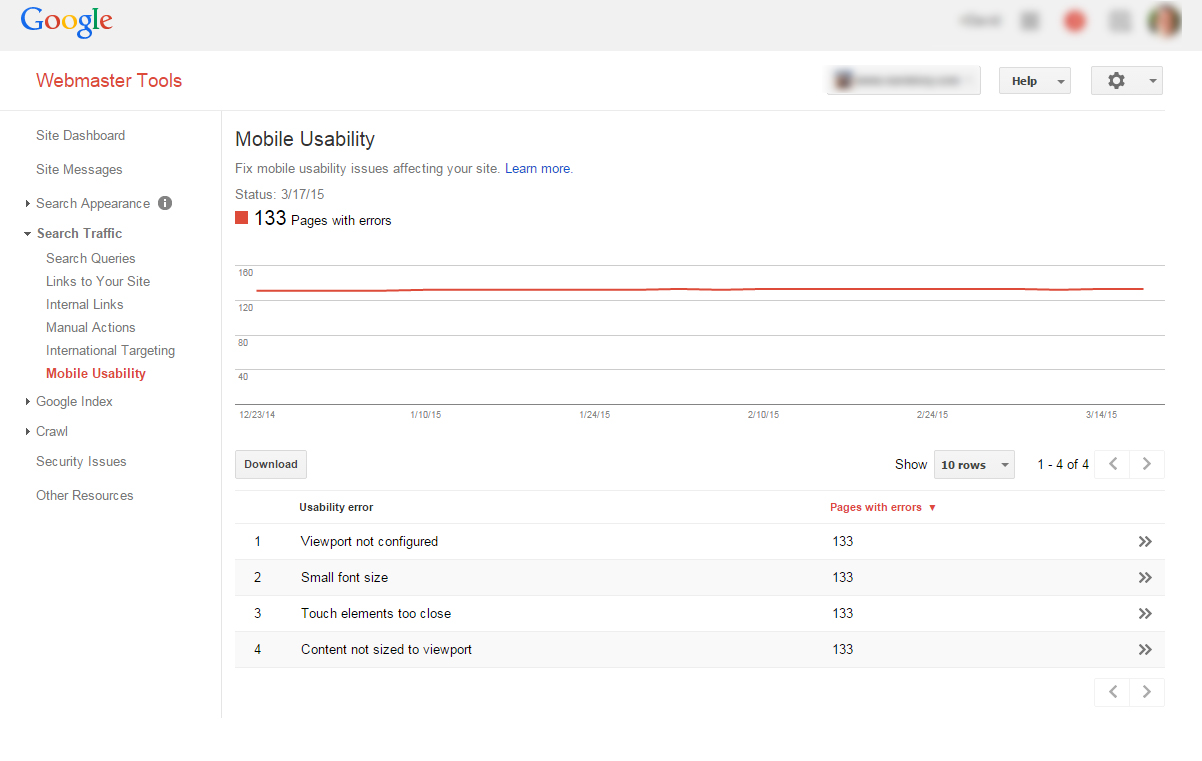

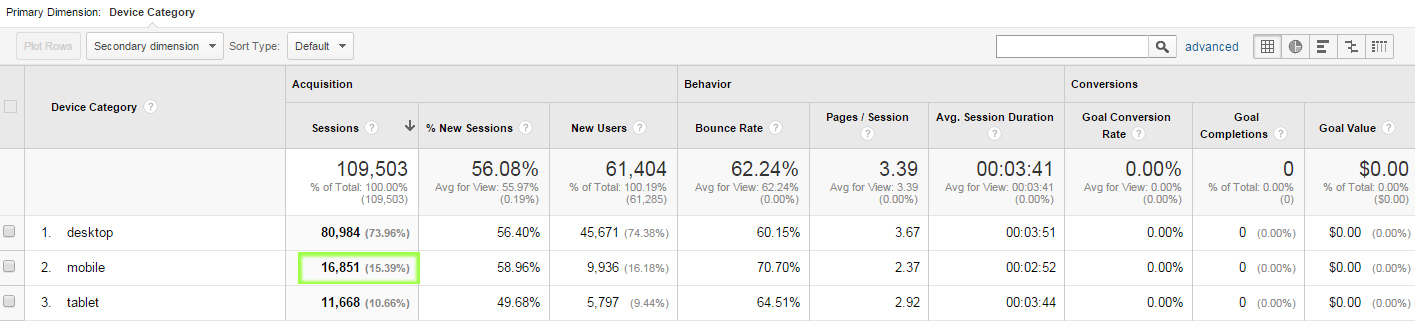

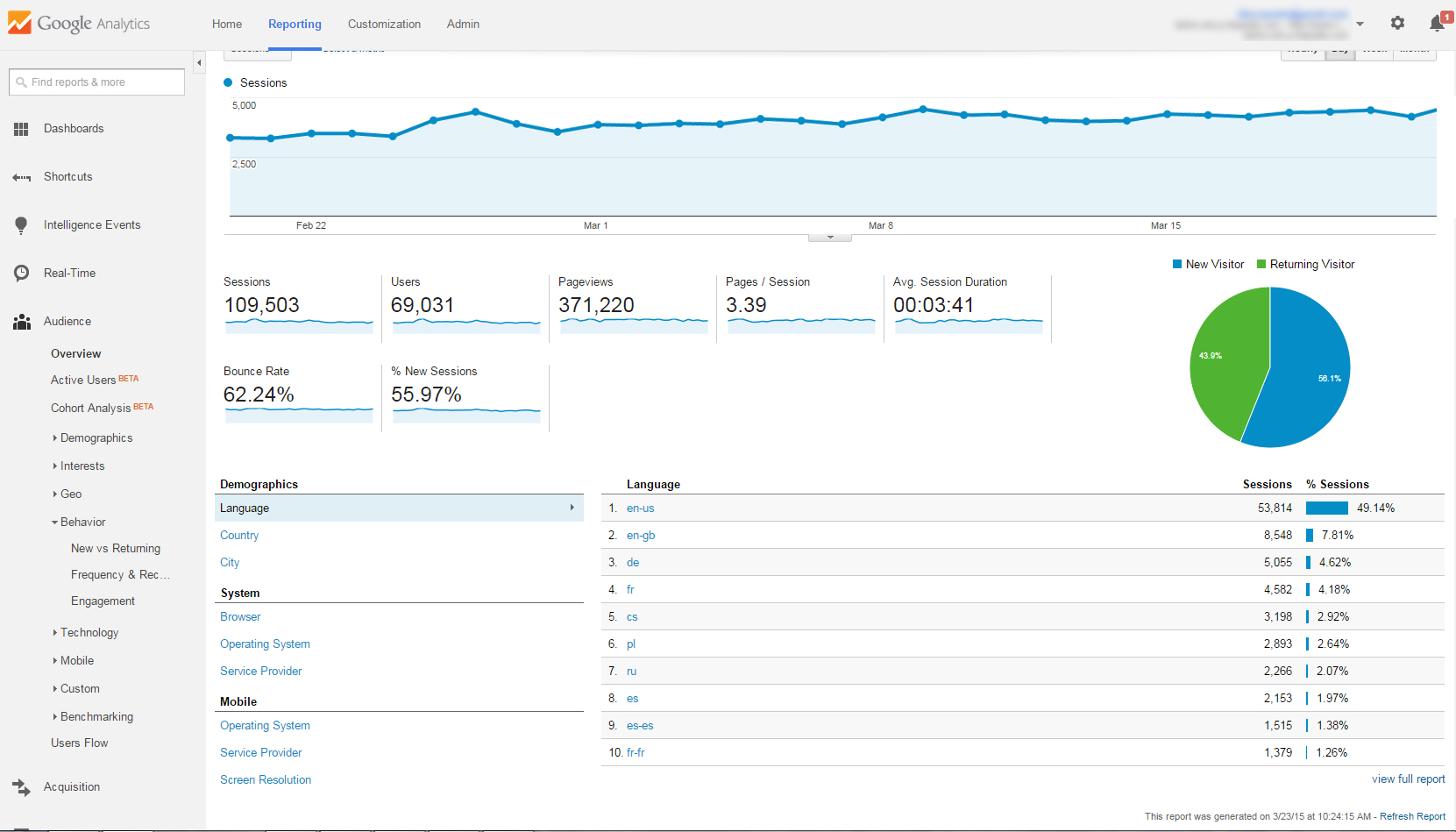

- Mesure intégrée du trafic; rapports de prospection conversions

- Utilisations d’analyse de mesure en temps réel sur le ROI (retour sur investissement).

- Utilisation de tableaux de bord de veille digitale pour surveiller les actions de ses concurrents et réagir.

L’Inbound Marketing consiste pour les entreprises non à « bombarder » ses prospects pour créer cette brand awareness, mais de créer une véritable relation se basant sur un marketing personnalisé et non intrusif. L’Inbound Marketing permet bien plus de souplesse pour entreprise dans l’interaction qu’elle peut avoir avec son public. Elle doit communiquer là où ses prospects se trouvent, comprendre ses attentes et problématiques et y répondre de manière personnalisée.

La création d’un contenu à valeur ajoutée peut se faire par du contenu à forte valeur ajouté depuis un blog, à traverse une stratégie de community management, ou encore la rédaction de livre blancs, de documentaires vidéos, slideshows… Ces actions contribueront au final à convaincre par d’autres moyens de son expertise sur son secteur d’activité, et consolider son image ou créer un univers fort et attractif autour de sa marque auquel le prospect fera le choix d’appartenir. Le mode de diffusion préféré pour les campagnes d’inbound marketing passent par les réseaux sociaux car ils permettent d’automatiser, cibler et personnaliser la diffusion et la curation de contenu. Au final: Il s’agit des bons contenus, vers les bons publics, et au bon moment. Et on ne le rappellera jamais assez, mais ce sont des actions de long terme, qui demandent avant tout de la souplesse et de l’endurance.

De nouveaux usages pour les entreprises

Cela représente à la foi une formidable opportunité pour les entreprises avant d’effectuer leur révolution numérique, mais aussi un risque en période de crise économique (avec une reprise qui se dessine pour celles qui font l’effort de la conversion !), car c’est un investissement de long terme, a faible impact immédiat. Le ROI ne vient qu’après une stratégie bien menée et bien accompagnée, où tous les acteurs de l’entreprise peuvent se joindre. C’est une étape logique de plus après l’arrivée de la veille atomisée au niveau des services et salariés plutôt que concentrée dans une cellule d’experts. En somme, l’Inbound Marketing fait appel à l’intelligence collective de l’entreprise.